Jennifer Dewan, Senior Director of Communications

Jennifer.dewan@tii.ae

UAEのテクノロジーイノベーション研究所が新しいアーキテクチャでAI言語モデルを革新

- アブダビ、アラブ首長国連邦 - 火曜日, 13. 8月 2024

- AETOSWire

- Falcon Mamba 7Bは、Hugging Faceによって独立して検証された、世界で最も高性能なオープンソースの状態空間言語モデル(SSLM)です

- SSLM(状態空間言語モデル)はメモリコストが低く、任意の長さのテキストブロックを生成するために追加のメモリを必要としません

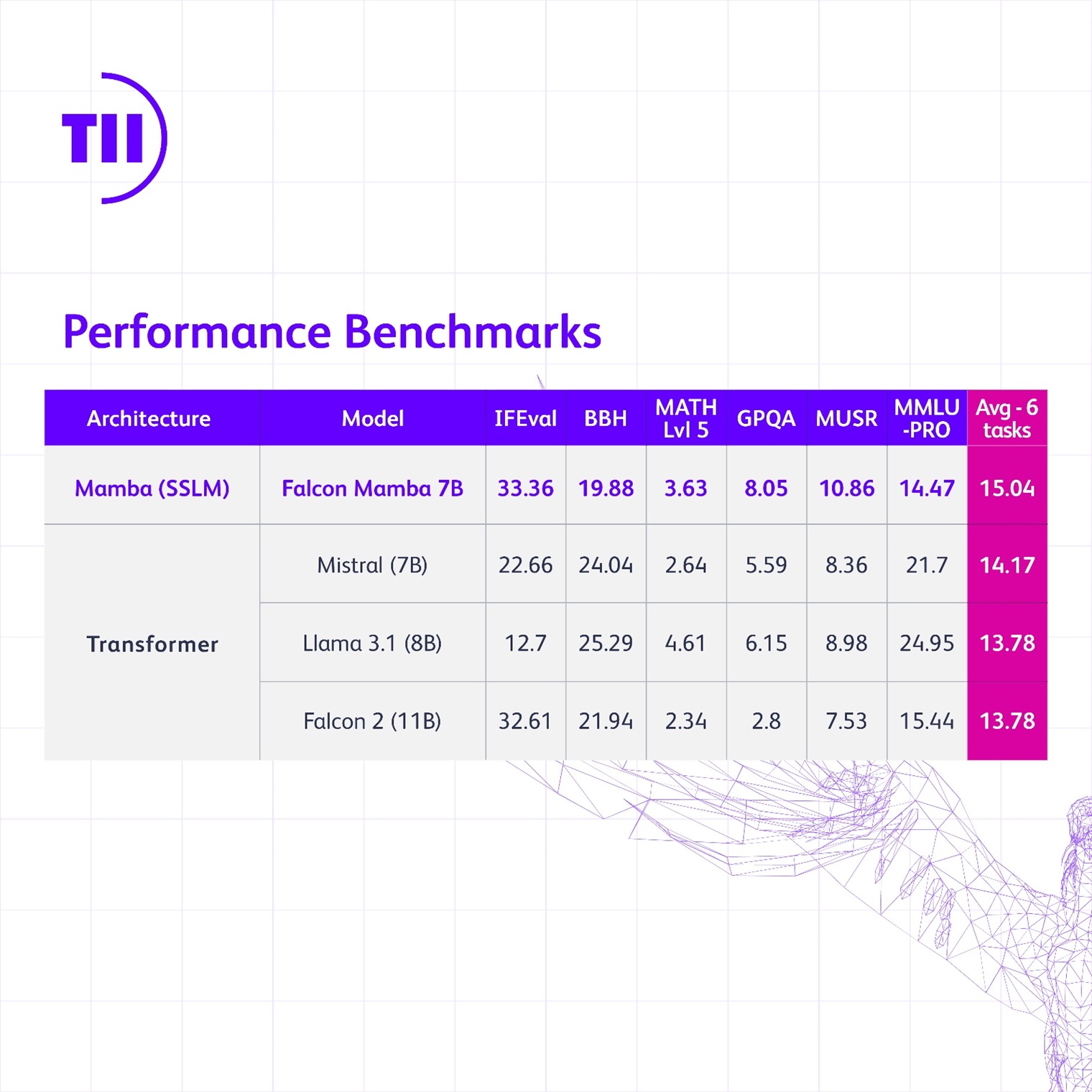

- Falcon Mamba 7Bは、MetaのLlama 3.1 8BやMistralの7Bなどの従来のトランスフォーマーアーキテクチャモデルをも上回ります

- 新しいモデルは、アブダビのAI研究と開発における革新と先駆的なアプローチを反映しています

テクノロジーイノベーション研究所(TII)、世界的な科学研究の先端機関であり、アブダビの応用研究の柱である先端技術研究評議会 (ATRC)は、Falconシリーズの新しい大規模言語モデル、Falcon Mamba 7Bを発表しました。この新しいモデルは、Hugging Faceによって独立して検証された、世界で最も高性能なオープンソースの状態空間言語モデル(SSLM)です。

Falconの最初のSSLMとして、このモデルは従来のすべてのFalconモデルがトランスフォーマーアーキテクチャを使用していたのとは異なります。この新しいFalcon Mamba 7Bモデルは、研究所が行っている先駆的な研究と、オープンソース形式でコミュニティに提供する画期的なツールや製品のもう一つの例です。

H.E. ファイサル・アル・バンナイ、ATRCの事務総長およびUAE大統領の戦略研究と先端技術担当顧問は次のように述べました:「Falcon Mamba 7Bは、TIIによる4回連続でのトップランクAIモデルを示し、アブダビをAI研究と開発の世界的な拠点として強調します。この成果は、UAEの革新への揺るぎないコミットメントを際立たせています。」

トランスフォーマーアーキテクチャモデルにおいて、Falcon Mamba 7BはMetaのLlama 3.1 8B、Llama 3 8B、およびMistralの7BをHuggingFaceの新しく導入されたベンチマークで上回ります。一方、他のSSLMにおいては、Falcon Mamba 7Bが旧ベンチマークで他のすべてのオープンソースモデルを超え、HuggingFaceの新しい厳しいベンチマークリーダーボードで最初のモデルになるでしょう。

TIIの最高経営責任者であるナジュワ・アーラジ博士は次のように述べました:「テクノロジーイノベーション研究所は、FalconシリーズのAIモデルを通じて技術の限界を押し広げ続けています。Falcon Mamba 7Bは、真の先駆的な成果を代表し、人間の能力を高め、生活を向上させる未来のAI革新への道を切り開きます。」

状態空間モデルは、時間と共に進化する複雑な状況、例えば一冊の本全体を理解するのに非常に優れています。これは、SSLM(状態空間言語モデル)がそのような大量の情報を処理するために追加のメモリを必要としないためです。

一方、トランスフォーマーに基づくモデルは、シーケンス内で以前に処理した情報を記憶し、利用するのに非常に効率的です。これにより、コンテンツ生成などのタスクに非常に優れていますが、すべての単語を他のすべての単語と比較するため、かなりの計算能力を必要とします。

SSLM(状態空間言語モデル)は、推定、予測、制御タスクなどのさまざまな分野で応用可能です。トランスフォーマーアーキテクチャモデルと同様に、自然言語処理タスクでも優れた性能を発揮し、機械翻訳、テキスト要約、コンピュータビジョン、音声処理などに応用できます。

TIIのAIクロスセンターユニットの代理主任研究員であるハキム・ハシッド博士は次のように述べました:「Falcon Mamba 7Bを導入するにあたり、その開発を育んだTIIの協力的なエコシステムを誇りに思います。このリリースは重要な前進を示しており、新たな視点を刺激し、知能システムへの探求をさらに促進しています。TIIでは、SSLMとトランスフォーマーモデルの両方の限界を押し広げ、生成AIにおけるさらなる革新を引き起こそうとしています。」

Falcon LLMは4,500万回以上ダウンロードされており、モデルの優れた成功を証明しています。Falcon Mamba 7Bは、AIの責任ある使用を促進する受け入れ可能な使用ポリシーを含むApache 2.0ベースのソフトウェアライセンスであるTII Falcon License 2.0の下でリリースされます。新しいモデルに関する詳細は、FalconLLM.TII.aeで確認できます。

本記者発表文の公式バージョンはオリジナル言語版です。翻訳言語版は、読者の便宜を図る目的で提供されたものであり、法的効力を持ちません。翻訳言語版を資料としてご利用になる際には、法的効力を有する唯一のバージョンであるオリジナル言語版と照らし合わせて頂くようお願い致します。