Jennifer Dewan, Senior Director of Communications

Jennifer.dewan@tii.ae

UAE's Technology Innovation Institute revolutioneert AI-taalmodellen met nieuwe architectuur

- ABU DHABI, Verenigde Arabische Emiraten - dinsdag, 13. augustus 2024

- AETOSWire

- De Falcon Mamba 7B is de nr. 1 wereldwijd presterende open source State Space Language Model (SSLM), volgens onafhankelijke verificatie door Hugging Face

- SSLM's kosten weinig geheugen en hebben geen extra geheugen nodig om willekeurig lange tekstblokken te genereren

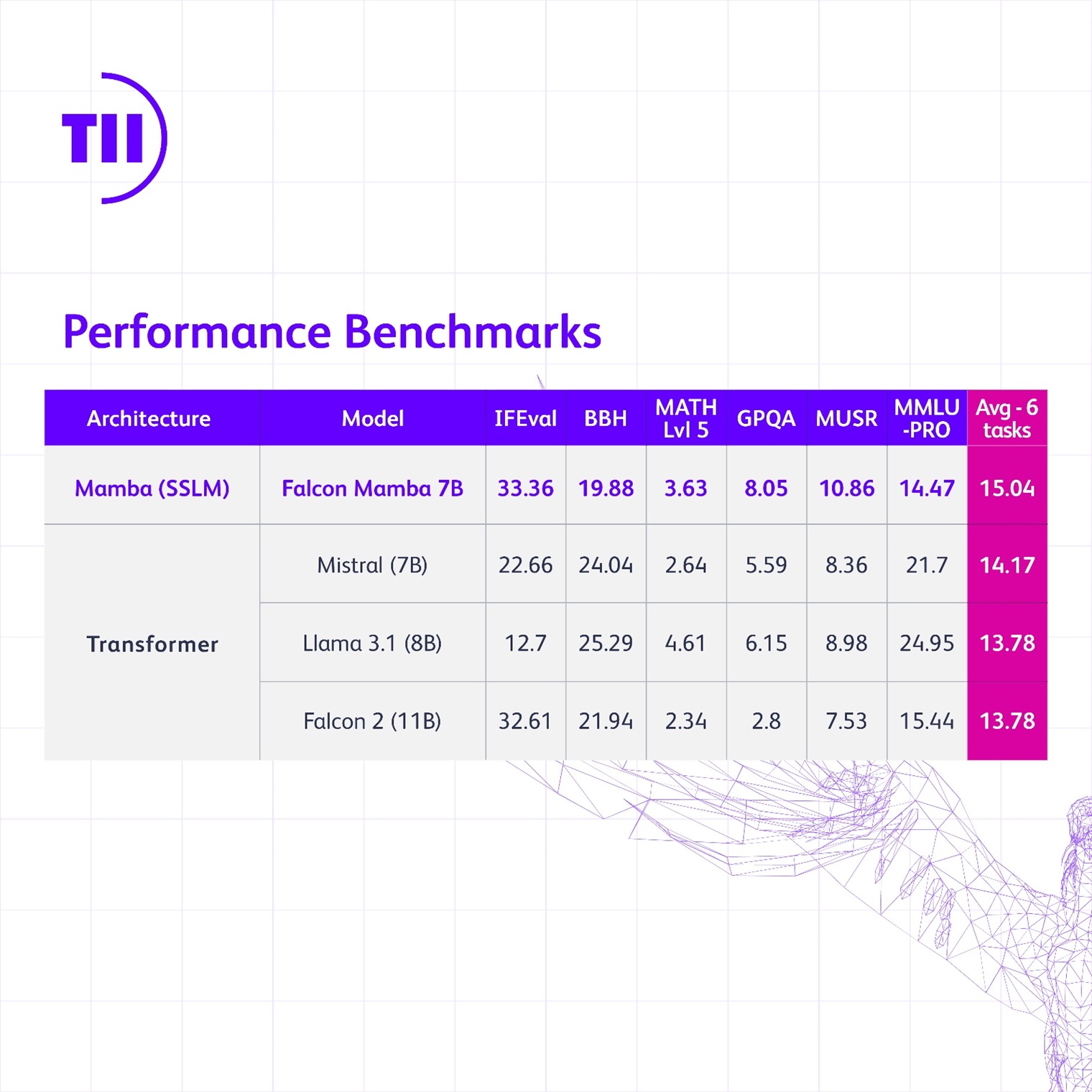

- Falcon Mamba 7B presteert ook beter dan traditionele transformatorarchitectuurmodellen zoals Llama 3.1 8B van Meta en 7B van Mistral

- Nieuw model toont de innovatie en baanbrekende aanpak van Abu Dhabi op het gebied van AI-onderzoek en -ontwikkeling

Het Technology Innovation Institute (TII), een toonaangevend wereldwijd onderzoekscentrum en de toegepaste onderzoekstak van Abu Dhabi Advanced Technology Research Council (ATRC), heeft een nieuw groot taalmodel uitgebracht in zijn Falcon serie, de Falcon Mamba 7B. Het nieuwe model is het nr. 1 wereldwijd presterende open source State Space Language Model (SSLM), volgens onafhankelijke verificatie door Hugging Face.

Het is de eerste SSLM voor Falcon die afwijkt van eerdere Falcon-modellen die allemaal een transformator-gebaseerde architectuur gebruiken. Dit nieuwe Falcon Mamba 7B model is opnieuw een voorbeeld van het baanbrekende onderzoek dat het instituut uitvoert en de doorbraaktools en producten die het beschikbaar stelt aan de gemeenschap in een open bronformaat.

Z.E. Faisal Al Bannai, secretaris-generaal van ATRC en adviseur van de president van de VAE voor strategisch onderzoek en geavanceerde technologiezaken, zei: “De Falcon Mamba 7B markeert TII's vierde opeenvolgende top AI-model en versterkt Abu Dhabi als wereldwijde hub voor AI-onderzoek en -ontwikkeling. Deze prestatie benadrukt de niet aflatende toewijding van de VAE aan innovatie."

Falcon Mamba 7B presteert op de nieuwe benchmarks voor transformatorarchitectuurmodellen beter dan Meta's Llama 3.1 8B, Llama 3 8B en Mistral's 7B van HuggingFace. Ondertussen verslaat de Falcon Mamba 7B alle andere open source modellen in de oude benchmarks en wordt het het eerste model op HuggingFace's nieuwe, zwaardere leaderboard.

Dr. Najwa Aaraj, Chief Executive van TII, zei: "Het Technology Innovation Institute blijft de grenzen van de technologie verleggen met zijn Falcon-serie AI-modellen. De Falcon Mamba 7B vertegenwoordigt echt pionierswerk en baant de weg voor toekomstige AI-innovaties die menselijke capaciteiten en levens zullen verbeteren."

State Space-modellen zijn zeer goed in het begrijpen van complexe situaties die in de loop van de tijd evolueren, zoals een heel boek. SSLM's hebben namelijk geen extra geheugen nodig om zulke grote hoeveelheden informatie te verwerken.

Transformatorgebaseerde modellen daarentegen zijn zeer efficiënt in het onthouden en gebruiken van informatie die ze eerder in een reeks hebben verwerkt. Dit maakt ze erg goed in taken zoals het genereren van inhoud. Omdat ze elk woord met elk ander woord vergelijken, vereist dit een grote rekenkracht.

SSLM's kunnen toepassingen vinden op verschillende gebieden, zoals schattingen, voorspellingen en controletaken. Net als de transformatorarchitectuurmodellen blinken ze ook uit in Natural Language Processing-taken en kunnen ze worden toegepast op automatische vertaling, tekstsamenvattingen, computervisie en audioverwerking.

Dr. Hakim Hacid, waarnemend hoofdonderzoeker van de TII AI Cross-Center Unit, zei: "Nu we de Falcon Mamba 7B introduceren, ben ik trots op het samenwerkende ecosysteem van TII dat de ontwikkeling ervan heeft bevorderd. Deze release is een belangrijke stap voorwaarts, die nieuwe perspectieven biedt en de zoektocht naar intelligente systemen verder aanspoort. Bij TII verleggen we de grenzen van zowel SSLM als transformatormodellen om verdere innovatie in generatieve AI te stimuleren."

Falcon LLM's zijn meer dan 45 miljoen keer gedownload, wat het uitstekende succes van de modellen bewijst. Falcon Mamba 7B wordt uitgebracht onder de TII Falcon License 2.0, de permissieve Apache 2.0-gebaseerde softwarelicentie die een aanvaardbaar gebruiksbeleid bevat dat het verantwoord gebruik van AI promoot. Meer informatie over het nieuwe model is te vinden op FalconLLM.TII.ae.

Deze bekendmaking is officieel geldend in de originele brontaal. Vertalingen zijn slechts als leeshulp bedoeld en moeten worden vergeleken met de tekst in de brontaal, die als enige rechtsgeldig is.

Contacts

Languages

Multimedia

Tweets by TIIuae