Дженнифер Дуан, старший директор по коммуникациям

Институт технологических инноваций ОАЭ выпускает языковые ИИ-модели с новой революционной архитектурой

- Абу-Даби, Объединенные Арабские Эмираты - вторник, 13. августа 2024

- AETOSWire

- По независимой оценке Hugging Face, Falcon Mamba 7B — это ведущая глобальная языковая модель пространства состояний (SSLM).

- SSLM отличаются низкой стоимостью использования и не требуют дополнительной памяти для генерации произвольных длинных блоков текста.

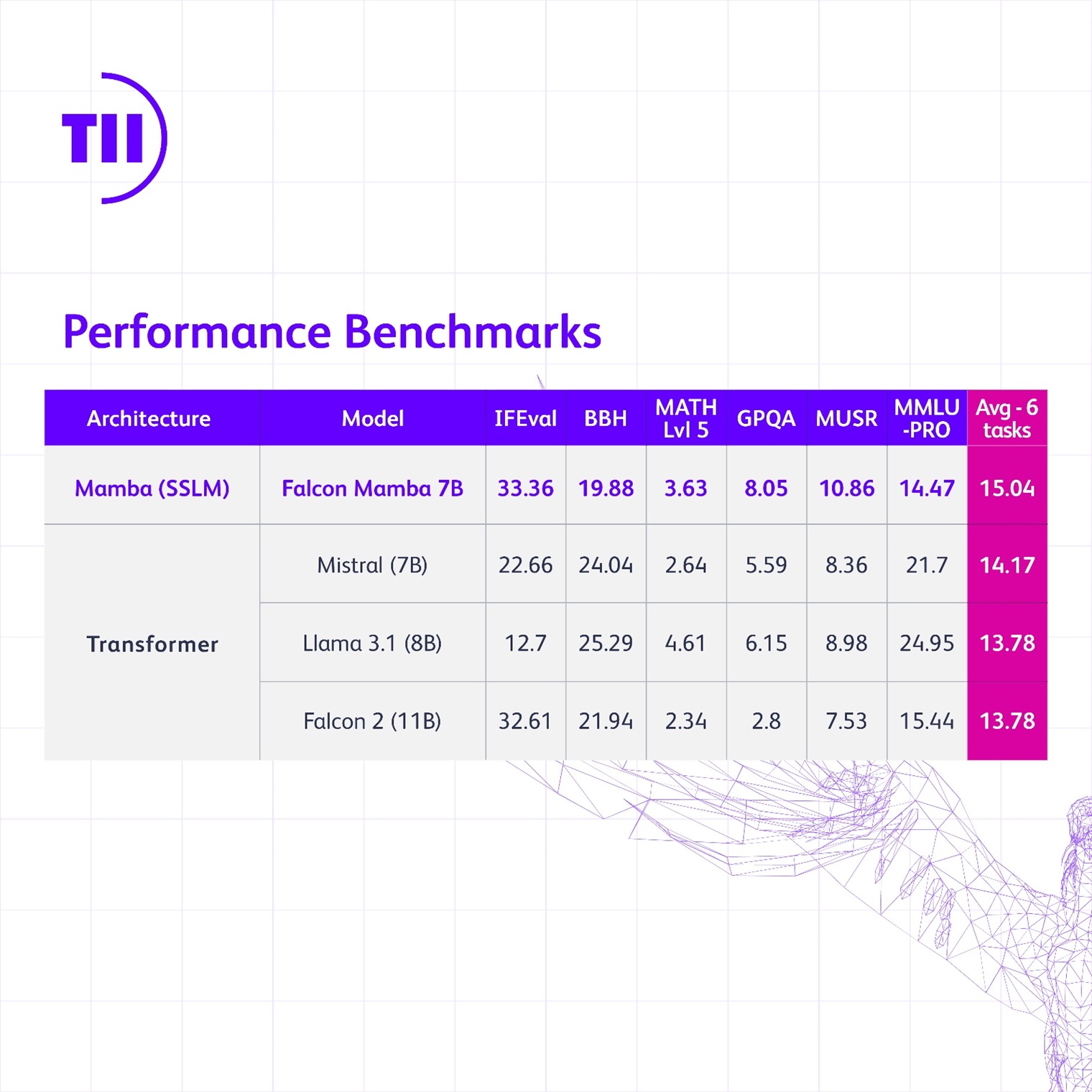

- Falcon Mamba 7B также выигрывает по сравнению с такими традиционными моделями с архитектурой трансформеров, как Meta Llama 3.1 8B и Mistral 7B.

- Новая модель отражает инновационный подход Абу-Даби к исследованиям и разработкам в области ИИ.

Институт технологических инноваций (TII) — ведущий международный центр научных и прикладных исследований Совета по исследованиям в области передовых технологий Абу-Даби (ATRC) — запустил новую большую языковую модель из серии Falcon под названием Falcon Mamba 7B. По независимой оценке Hugging Face, Falcon Mamba 7B — это ведущая в мире глобальная языковая модель пространства состояний (SSLM).

Будучи первой моделью SSLM в серии Falcon, она отличается от предыдущих версий с архитектурой трансформеров. Falcon Mamba 7B — еще один пример новаторских исследований, проводимых институтом, а также революционных инструментов и продуктов, выпускаемых с открытым исходным кодом, а значит, доступных для всех.

Его Превосходительство Фейсал Аль-Баннаи, генеральный секретарь ATRC и советник президента ОАЭ по стратегическим исследованиям и передовым технологиям, отмечает: «Falcon Mamba 7B знаменует собой четвертую подряд ведущую ИИ-модель от TII, что укрепляет позиции Абу-Даби в качестве глобального центра исследований и разработок в области ИИ. Это достижение еще раз свидетельствует о непоколебимой приверженности ОАЭ инновациям».

Недавние тесты Hugging Face продемонстрировали превосходство Falcon Mamba 7B перед такими моделями с архитектурой трансформеров, как Llama 3.1 8B, Llama 3 8B и Mistral 7B. Что касается других SSLM, Falcon Mamba 7B выигрывает по сравнению с остальными моделями с открытым исходным кодом и занимает ведущие позиции в новой таблице лидеров Hugging Face с более высокими показателями.

Д-р Наджва Аарадж, исполнительный директор TII: «Институт технологических инноваций продолжает открывать новые горизонты с помощью серии ИИ-моделей Falcon. Falcon Mamba 7B представляет собой истинно новаторскую работу и прокладывает путь для будущих инноваций в области ИИ, способных расширить возможности людей и улучшить их жизни».

Модели пространства состояний чрезвычайно эффективны для понимания сложных ситуаций, которые развиваются с течением времени (например, целая книга). Это связано с тем, что SSLM не требуют дополнительной памяти для обработки таких больших битов информации.

С другой стороны, модели на основе трансформеров очень эффективны при запоминании и использовании данных, обработанных ранее в последовательности. В связи с этим они хорошо подходят для таких задач, как создание контента. Однако, поскольку такие модели сравнивают каждое слово с другим, этот процесс требует значительной вычислительной мощности.

SSLM могут использоваться в различных областях, включая оценку, прогнозирование и управление. Подобно моделям с архитектурой трансформеров, они также отлично справляются с обработкой естественного языка и могут применяться для выполнения таких задач, как машинный перевод, обобщение текста, компьютерное зрение и обработка аудиоданных.

Д-р Хаким Хасид, исполняющий обязанности главного научного сотрудника центрального подразделения ИИ в TII, поясняет: «Представляя Falcon Mamba 7B, я чувствую гордость за созданную коллективными усилиями экосистему TII, которая способствовала развитию модели. Этот релиз — огромный шаг вперед, вдохновляющий на новые перспективы и укрепляющий наше стремление к исследованию интеллектуальных систем. В TII мы расширяем границы моделей SSLM и трансформеров, чтобы стимулировать дальнейшие инновации в области генеративного ИИ».

LLM от Falcon были загружены более 45 миллионов раз, что доказывает невероятный успех этих моделей. Falcon Mamba 7B предоставляется по TII Falcon License 2.0, разрешительной лицензии на программное обеспечение на основе Apache 2.0. Она предусматривает политику приемлемого использования, способствующую ответственному применению ИИ. Подробнее о новой модели читайте на сайте FalconLLM.TII.ae.